Uno dei problemi che pone la driverless car, come qualsiasi altro tipo di intelligenza artificiale, è certamente il cosiddetto dilemma morale: l’intelligenza artificiale non ha coscienza, cioè non ha (ancora) come l’essere umano un sistema di valori personali che lo indirizza nelle decisioni in cui una scelta completamente data-driven non esiste, perchè magari si è davanti a due opzioni equivalenti che, nella AI generano impasse.

Qualche tempo fa avevamo parlato di come al Mit di Boston si fossero posti il problema, ideando un giochino online, la Moral Machine, per raccogliere dati che permettessero di individuare in che modo le persone prendono decisioni quando sono in auto nelle situazioni di probabile incidente: investiremmo un cane per salvare una persona, o viceversa? Sacrificheremmo una persona atletica o una persona grassa? Una persona qualunque o un medico che aiuta gli altri? La nostra stessa vita o un gruppo di bambini?

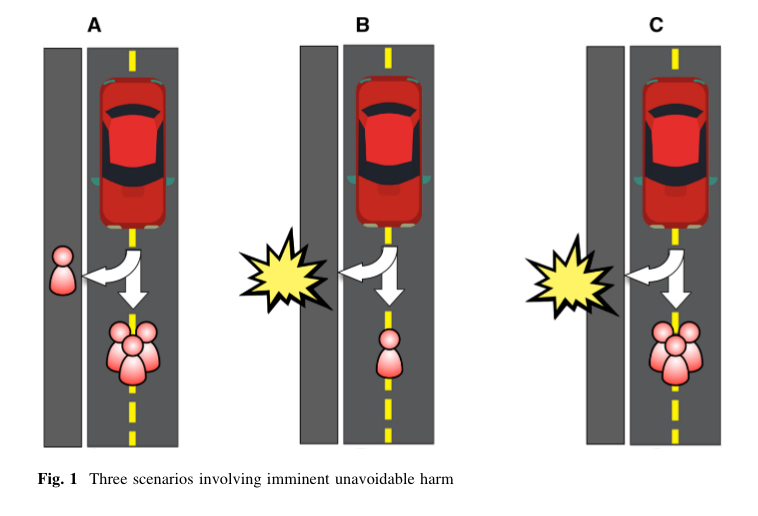

Sono scenari realistici e possibili anche nella circolazione stradale più sicura, predeterminata e senza grandi sorprese che ci porterà la driverless car, ma un azzeramento totale degli incidenti stradali non ci sarà mai.

Quindi, come vorremmo fosse affrontato dalla macchina lo scenario incidente? Ci piacerebbe essere noi stessi a decidere quali vite salvare? O preferiremmo una driverless car totalmente preimpostata, in cui la responsabilità di tali scelte grava tutta sul costruttore?

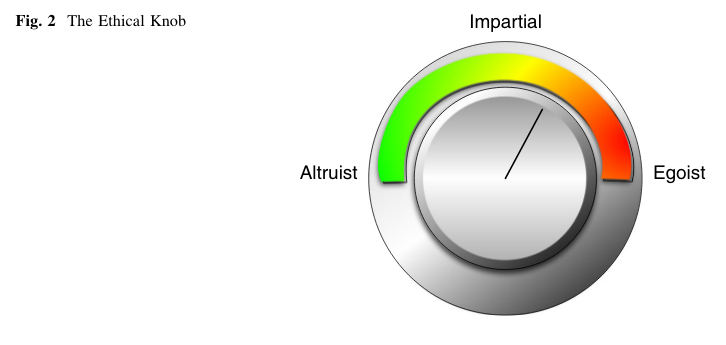

Tre giuristi, Giuseppe Contissa, Giovanni Sartor, Francesca Lagioia del CIRSFID (un centro interdipartimentale di ricerca dell’Università di Bologna), team si occupa da tempo dei problemi giuridici legati alla robotica e all’intelligenza artificiale, si è posta esattamente questo problema, arrivando a concepire (per ora teoricamente) un ‘ethical knob’ ovvero ‘la manopola etica’.

La manopola etica è un dispositivo che consente al guidatore di predeterminare l’importanza che attribuisce alla propria vita (e quella dei passeggeri) rispetto a quella degli estranei e di influenzare le scelte dell’auto in caso di incidente inevitabile. La scelta di come settare la manopola è bilanciata dal calcolo della probabilità di un certo evento e della possibile gravità del danno subito dalle parti. Il posizionamento della manopola su posizione altruistica, imparziale o egoistica, può determinare il comportamento del veicolo in diversi scenari e da queste scelte possano discendere eventuali responsabilità giuridiche delle parti coinvolte (in particolare utilizzatore e produttore).

Abbiamo posto a Giuseppe Contissa e Francesca Lagiola alcune domande.

Secondo voi un dispositivo come la ethical knob è realistico? potrà essere accettato dalle persone? Non consegna troppa responsabilità all’essere umano?

È troppo presto per poter dire se l’ethical knob sia una soluzione che potrà essere adottata. Ci sembra che però che ci costringa a riflettere su come vogliamo relazionarci nel prossimo futuro ai sistemi intelligenti (macchine, robot, algoritmi e sistemi di intelligenza artificiale in genere), ovvero se vogliamo che questi sistemi siano estensione della volontà, dei desideri e della morale dei singoli individui, e quindi favorirli (entro i limiti consentiti dalla legge) o se piuttosto debbano essere entità imparziali, che operano sulla base di una etica pubblica dettata dagli ordinamenti giuridici, o dagli standard dettati dal mercato. Può essere che la scelta vari a seconda del dominio di applicazione, per esempio un BOT che gioca in borsa dovrebbe perseguire gli interessi del suo utilizzatore o essere neutrale rispetto a gli interessi di tutte le parti in gioco? Per quanto riguarda la possibilità che le persone accettino o meno un dispositivo di questo tipo e la responsabilità che ne consegue, la scelta etica rimarrebbe nell’ambito della responsabilità individuale del singolo utilizzatore. D’altra parte, sulla base degli esperimenti condotti all’interno del progetto Moral Machine del MIT, ci sembra che la possibilità di un veicolo pre-programmato, che privilegi in certi casi la vita dei terzi rispetto a quella dei passeggeri, non risolva i problemi etici e che spesso le persone siano riluttanti all’idea di salire a bordo di un veicolo pre-programmato.

La manopola etica potrebbe effettivamente avere – come riporta il vostro paper – un effetto positivo nell’ingresso sul mercato delle auto autonome? Quanto pesa il tema etico nello sviluppo delle auto autonome?

L’ethical knob potrebbe facilitare l’accettazione dei veicoli autonomi da parte dei singoli individui, perché permetterebbe loro di mantenere un controllo su alcune scelte che altrimenti verrebbero loro sottratte. In ogni caso gli ordinamenti giuridici dovrebbero stabilire i limiti consentiti del livello di rischio a cui sottoporre la vita di terzi. Il tema etico è fondamentale nello sviluppo dei veicoli autonomi e gli ordinamenti devono farsi carico di questo problema (come già alcuni stanno facendo, vedi ad esempio le iniziative in Germania).

Si dice che uno dei grandi vantaggi delle auto autonome è che ridurranno drasticamente gli incidenti stradali, quindi gli scenari ‘incidente’ non dovrebbero essere marginali?

L’adozione dei veicoli autonomi ridurrà certamente il numero di incidenti, almeno quelli dovuti ad errore umano, tuttavia, i casi in cui per esempio, ci sia un malfunzionamento dei freni, o il veicolo che precede perda olio sulla strada, o un gruppo di ragazzini attraversi la strada improvvisamente, non sono ipotesi così marginali o infrequenti.

Sotto il profilo assicurativo, la manopola etica che impatto avrebbe?

Sicuramente l’ethical knob produrrebbe cambiamenti nel campo assicurativo, ad esempio l’impostazione del knob su un livello molto elevato di egoismo (o perfino di altruismo, qualora il numero dei passeggeri a bordo sia maggiore dei terzi), produce un rischio maggiore per la sicurezza stradale e un ammontare maggiore di danni risarcibili. In queste ipotesi, le assicurazioni potrebbero prevedere un premio assicurativo più elevato. Al contrario, nell’ipotesi di un veicolo pre-programmato, un premio assicurativo più elevato potrebbe ricadere sui produttori.

L’ethical knob rimarrà solo una ricerca teorica o prevedete sperimentazioni?

Abbiamo iniziato a disegnare alcuni esperimenti ma il lavoro è ancora all’inizio e per ora non possiamo anticipare alcun tipo di risultato.

*Giuseppe Contissa è ricercatore al CIRSFID e insegna Informatica Giuridica alla LUISS di Roma. Ha svolto 2 post doc, uno presso l’università di Stanford negli stati Uniti, come resident fellow presso il Codex (centro di Informatica Giuridica), ed uno presso l’EUI come Max Weber Postdoctoral Fellow. Francesca Lagioia lavora al CIRSFID come ricercatrice e all’EUI dopo aver vinto un post doc come Max Weber Postdoctoral Fellow con un progetto di ricerca sulla responsabilità penale legata allo sviluppo e all’uso di sistemi d’intelligenza artificiale.